ChatGPT模型架构基础深度解析

揭秘AI对话系统背后的核心技术原理,让你彻底搞懂ChatGPT如何工作

为什么ChatGPT如此强大?

老铁们,今天顾老师要带你们深入ChatGPT的架构基础,看看这个让全世界疯狂的AI到底是怎么炼成的!

ChatGPT的核心架构基于Transformer模型,这可是2017年Google大脑团队提出的革命性架构。它抛弃了传统的循环神经网络(RNN),改用自注意力机制(Self-Attention),让模型能够并行处理整个文本序列,大大提高了训练效率。

OpenAI CEO 萨姆·奥尔特曼

ChatGPT架构三大核心组件

- Transformer架构:多层编码器-解码器结构,每层都包含自注意力机制和前馈神经网络

- 自注意力机制:让模型能够动态关注输入序列中不同位置的信息,理解上下文关系

- 大规模预训练:在海量文本数据上进行无监督学习,掌握语言模式和世界知识

ChatGPT架构详解

1. 输入处理层

首先,输入的文本会被转换成词嵌入向量,再加上位置编码。这个位置编码特别重要,因为Transformer本身没有循环结构,需要通过位置编码来理解词语的顺序关系。

2. 多头注意力机制

这是Transformer最核心的部分!ChatGPT使用多头注意力,可以同时从多个角度理解词语之间的关系。比如"苹果"这个词,在一个头中可能关注"吃",另一个头关注"公司"。

3. 前馈神经网络

注意力层的输出会经过一个前馈神经网络进行进一步处理。这个网络由两个全连接层组成,中间有ReLU激活函数。

4. 层归一化和残差连接

每个子层后面都有层归一化和残差连接,这是训练深层网络的关键技术,可以有效防止梯度消失问题。

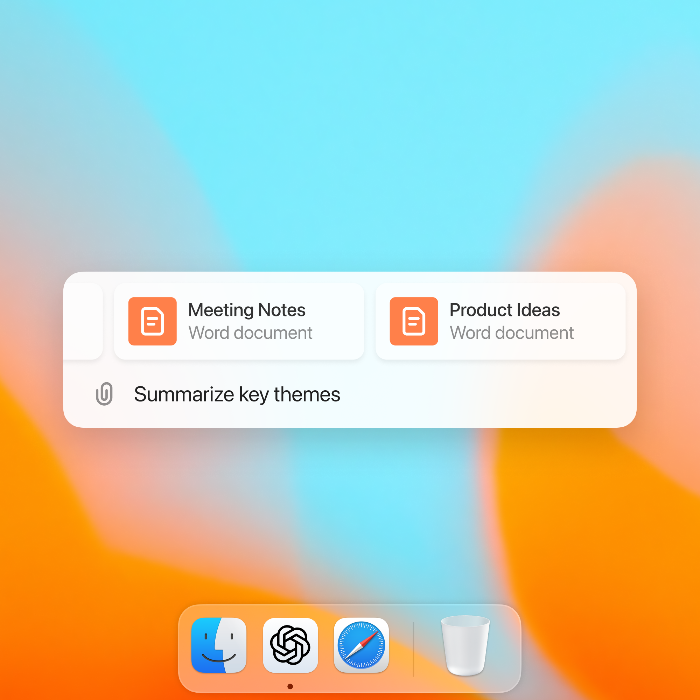

ChatGPT移动版界面

ChatGPT官方应用图标

立即体验ChatGPT

现在你已经了解了ChatGPT的架构基础,是时候亲自体验一下这个强大的AI助手了!

ChatGPT架构的独特优势

顾老师告诉你,ChatGPT之所以这么牛,全靠这几个杀手锏:

- 上下文理解能力超强:自注意力机制让它能够理解长距离依赖关系

- 并行处理效率高:Transformer架构可以并行处理整个序列,训练速度比RNN快得多

- 可扩展性强:模型可以通过增加层数和参数量不断提升性能

- 通用性强:同样的架构可以用于各种NLP任务,无需特别调整